Sur Azure DevOps vous avez accès à 2 types de pipelines. Les Pipelines qui s'écrivent principalement en code les Releases Pipelines qui se font principalement en clic. En fonction du…

Créer Pipeline avec Azure DevOps

Sur Azure DevOps vous avez accès à 2 types de pipelines. Les Pipelines qui s'écrivent principalement en code les Releases Pipelines qui se font principalement en clic. En fonction du…

Si comme moi vous avez décidé de faire du puppet dans le cloud ( oui il existe des courageux ) vous avez surement été dessus de constater que la vm…

Pour connecter Azure DevOps à Terraform Cloud dans le but de lancer des pipelines depuis Azure DevOps ou Terraform Cloud vers Azure il faut effectuer quelque configuration sur Azure, Azure…

La connexion entre Azure et Azure DevOps se fait via un service de connexion qui peux être créé directement depuis Azure DevOps. Dans mon cas, j'ai déjà créé un Ressource…

Si vous avez un cluster kubernetes vous allez rapidement vous trouver dans cette situation de certificat expiré. Vous pouvez utiliser une CA externe ou interne pour faire le renouvellement. Nous…

Hello everybody, we will start to learn about terraform. For this beginning tutoriel i will explain you how you can create simple machine with terraform on your proxmox. How terraform…

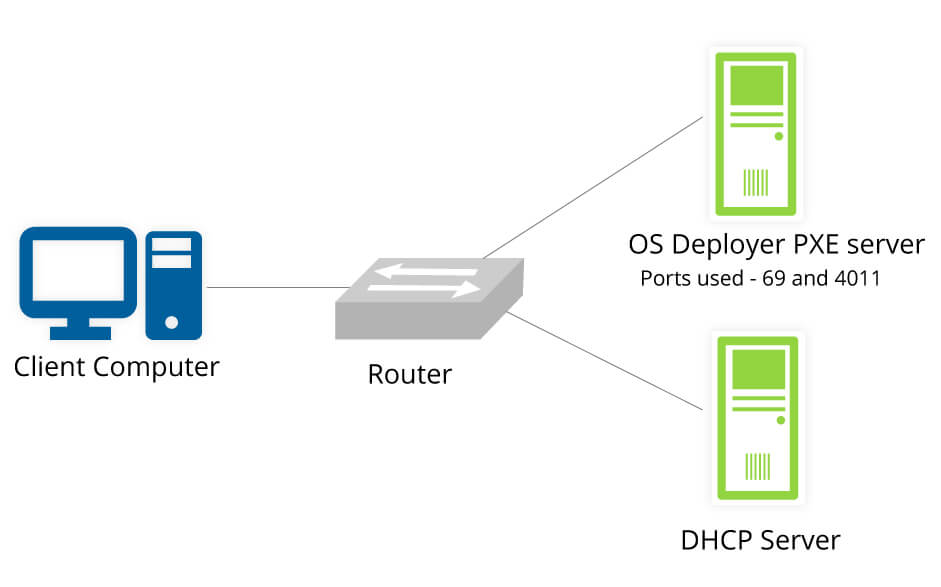

Hello everybody, we will learn how we can install debian, ubuntu or other linux over network. this is call Preboot execution environment (PXE), pronounced pixie, is a set of standards…

Let'sEncrypt is a very nice tool to create free certificate for your site. With Let'sEncrypt you need to use domaine validation if you want to create wilcard certificate. In our…

Terraform is very good tool and if you use it at local you quickly see the limite of local state and you will need to go to remote but if…

Nous allons voire durant tutoriel une méthode simple qui permet de déployer proxmox avec ansible en utilisant le rôle lae.proxmox disponible sur ansible galaxy mais également sur Github. Nous partons…